미국 Z세대에게 유튜브란?

Editor's Comment

구글과 아마존, 아마존과 구글. 생활 속에서, 또 기사에서 하루에도 몇 번씩 접하는 이름입니다. 치열한 플랫폼 싸움에서 이 둘은 각각 어떤 기술을 발판으로 경쟁력을 쌓아가고 있을까요? '넥스트 미디어, 테크와 AI를 만나다 - 미디어가이 in 2018 NAB Show'의 두 번째 미리보기에서는 미디어가이가 구글에 주목한 부분을 발췌하여 소개합니다.

전문이 실린 디지털 콘텐츠는 5월 18일(금) 오후 5시까지 할인된 가격으로 예약 구매하실 수 있습니다. [바로 가기]

* 상단 이미지 ©Lindsay Henwood/Unsplash

2018 NAB Show AI 부문에서 구글의 기술을 체험할 수 있는 SDK(software development kit,) API(application programming interface)는 아마존과 비교할 때 많지 않았습니다. (아마존과 구글의 대결 구도를 분석한 자세한 내용은 최종 리포트에 이어집니다.) 그럼에도 미디어 입장에서는 구글이 가진 레퍼런스(reference)와 스토리가 탐나는 것이 사실입니다.

왜냐하면 구글에게는 전 세계 Z세대(generationZ)*와 밀레니얼스(millennials)**를 사로잡은 서비스이자, 월 15억 명이 사용하는 유튜브가 있기 때문이죠.

* 1990년대 중반부터 2000년대 중반까지 태어난 세대

** 1980년대부터 1990년대 중반까지 태어난 세대

2017년 NAB Show에서는 대부분의 업체가 넷플릭스*를 모방해 서비스를 만들 수 있다는 환상을 보여 줬다면, 2018년은 어떻게 하면 유튜브에서 AI를 통해 시간을 단축하면서도 좋은 콘텐츠를 만들 수 있을지를 두고 많은 이야기가 오고갔습니다. 특히 짧은 영상(short-clip) 등을 만들 때 말이죠.

* 지난 분기까지 가입자만 1억 2천 5백만 명을 모집한 유료 OTT(over the top )플랫폼. 한국에서도 2016년 이후 서비스를 시작했으며, <옥자>, <범인은 바로 너!>와 같은 오리지널을 제작했다.

물론 이런 영상들은 페이스북, 스냅챗, 인스타그램에서도 사용되지만, 현재까지 광고 수익을 낼 수 있게 해주는 곳은 유튜브뿐입니다. AI를 표방하며 영상을 만들어 주는 업체들도 유튜브에서 큐레이션이 잘 된다는 점을 강조하고 있을 정도니까요.

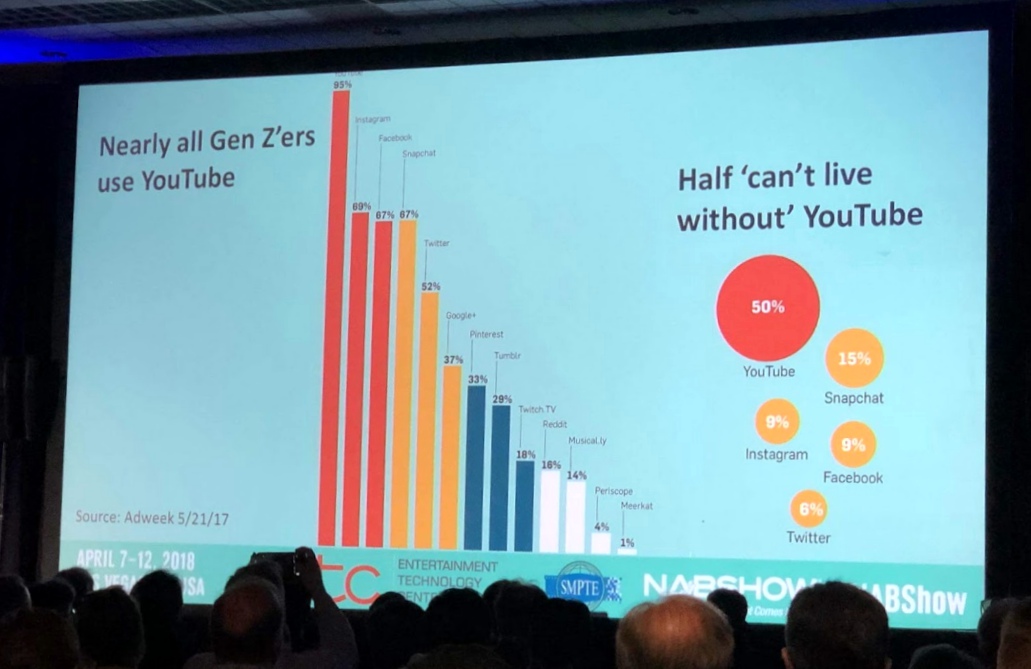

유튜브는 미국 Z세대가 90% 이상 사용하는 유일한 플랫폼이라고 합니다. 무려 95%입니다.

심지어 그중 50%는

유튜브가 없으면

살 수 없다고 했답니다

2018 NAB Show에서 발표된 자료. 통계 출처는 애드위크 ⓒ김조한

이들은 TV나 페이스북은 없어도 별문제 없지만, 유튜브가 없으면 살 수 없다고 합니다. 최근 들어 상승세가 주춤하지만 Z세대에게 딱이라던 스냅챗도 사용률이 67%인데 말입니다. 한국도 상황은 별반 다르지 않습니다. 대한민국에서 가장 많이 쓰는 동영상 앱 역시 유튜브입니다.

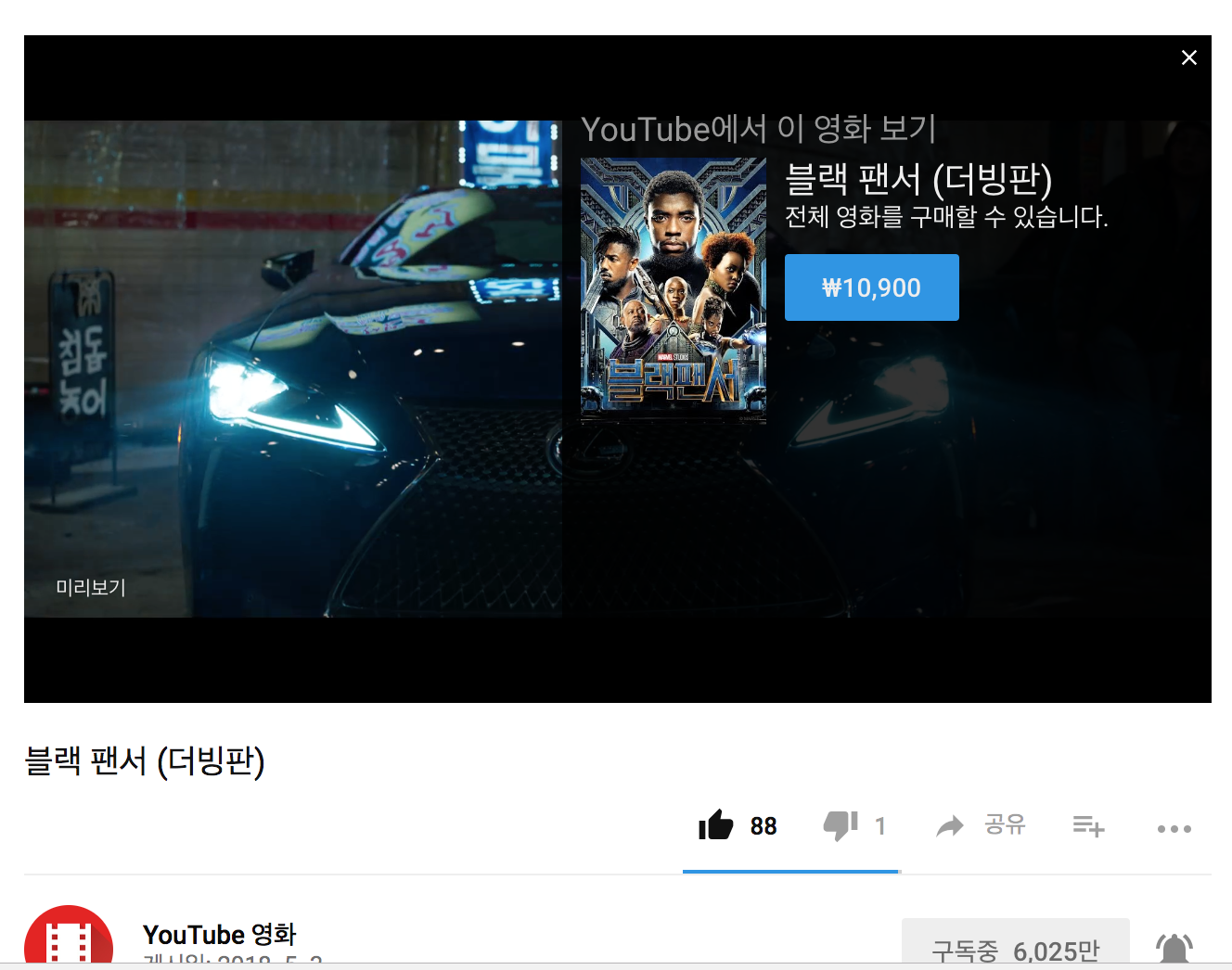

앞으로 10년 후, 지금의 밀레니얼스가 될 수 있는 Z세대가 유튜브에 빠져 있다면, 미디어 회사들이 꿈꾸는 미디어 플랫폼의 롤모델은 유튜브가 될 수밖에 없습니다. 그게 어렵다면 유튜브에 올라타는 것도 방법일 수 있겠지요. 많은 영화사가 이미 유튜브를 통해 영화를 유통하고 있습니다. 안드로이드 기기의 경쟁 플랫폼인 애플의 iOS 기기에서도 유튜브는 볼 수 있으니까요.

영화 <블랙 팬서>를 유튜브에서 팔고 있는 디즈니 ⓒYouTube

2017년 말, 구글은 실시간 방송의 데이터 분석과 광고 혁신을 위해 유튜브 TV를 북미 시장에 론칭합니다. 전 세계 15억 인구가 매달 쓰는 유튜브, 오리지널 콘텐츠가 포함된 유튜브 레드 오리지널(Red Original), 그리고 실시간 방송 영역인 유튜브 TV까지. 그 누구보다 다양한 콘텐츠 포트폴리오와 강력한 고객 데이터를 가지고 있는 구글은 아마존과는 다른 AI 전략을 갖고 있습니다.

강력한 클라우드 플랫폼의 힘으로 비디오⋅오디오 데이터를 수집하려는 아마존과 달리, 구글은 아마존에게 밀리는 클라우드 플랫폼에서 우위를 점하기 위해 AI에 투자하는 게 아닐까 합니다. (중략)

구글이 이미지를 다루는 법

이미지를 처리하여 수많은 메타데이터를 생성하는 구글 비전(Vision)(여러분도 테스트할 수 있습니다.)은 훌륭합니다. 저도 데모를 보자마자 그날 찍은 컨퍼런스 사진들을 테스트해보았는데, 아마존의 비디오 인덱싱(video indexing)과는 조금 다른 느낌이었습니다. 일단 사람의 감정을 분석하는 기술이 상당한 수준으로 보였습니다.

웹 데모 결과, 9가지 카테고리로 나누어진 정보를 받을 수 있었습니다. 표정 인식(faces,) 상황 분석(labels), 텍스트(text) 인식을 예로 들어 보겠습니다.

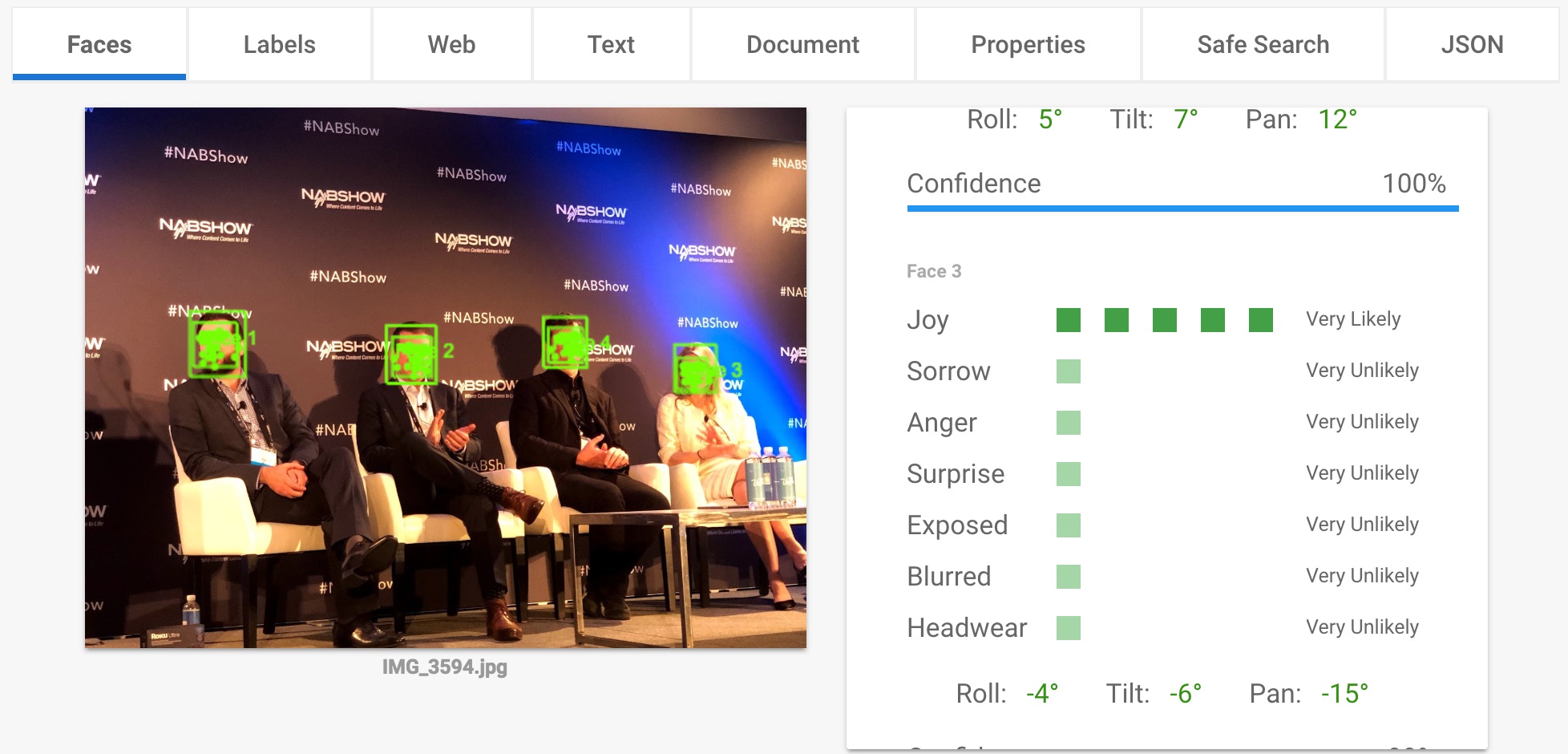

표정 인식

표정을 인식하는 faces탭 (사진 제공: 김조한)

위 사진에서 보듯 기쁨(joy), 슬픔(sorrow), 분노(anger), 놀람(surprise), 노출된(exposed), 모호한(blurred), 모자를 쓰고 있는(headwear )등으로 표정을 묘사합니다. 유튜브의 수석 임원인 레베카 도프(Rebekah Dopp)의 표정을 테스트했는데, 기쁨이 5개나 나오며 기쁠 가능성이 '매우 높다(very likely)'고 표현되었습니다. 물론 표정은 어두울지라도 마음만은 그렇지 않다는 사람도 있지만, 수많은 사진을 보고 이 정도로 분석해주는 기능은 매우 효율적이라고 생각합니다.

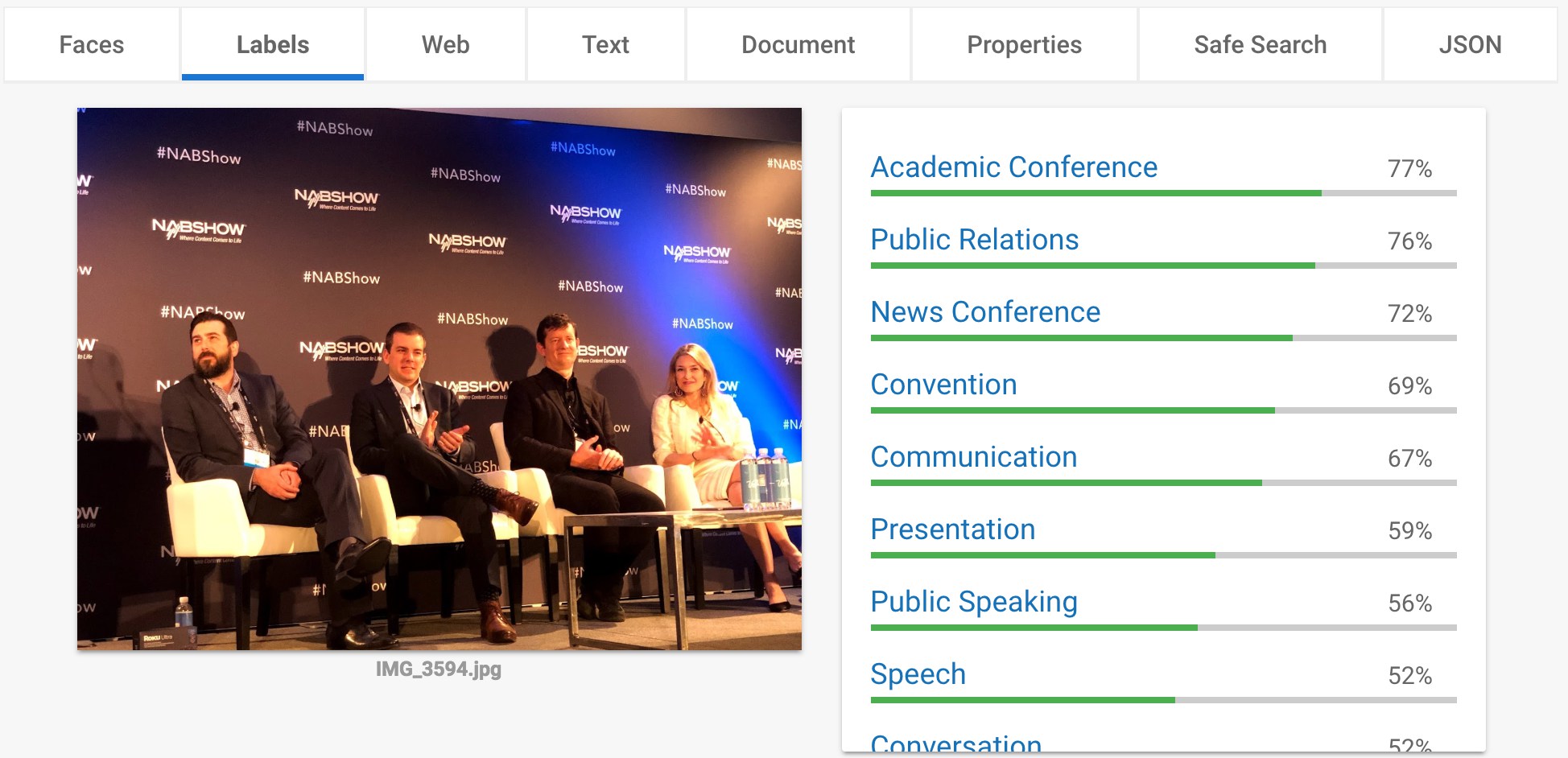

상황 분석

상황을 분석하는 labels탭 (사진 제공: 김조한)

구글 비전이 놀라웠던 부분 중 하나는 상황을 분석하는 디테일이었습니다. 위 사진을 넣었더니 컨퍼런스(conference)라고 분석해낸 결과가 상당히 정확했습니다. 혹시 사람들이 많으면 이렇게 인식하나 해서 부모님의 칠순 잔치 사진을 다시 올렸더니, 기념일(ceremony)이라고 인식하더군요. 신뢰도가 상당히 높아졌습니다.

아마존 레코그니션(Rekognition*)이 만드는 메타데이터는 정확도를 표현하지 않습니다. 다 같이 목차화된다는 표현이 맞을 겁니다. 이에 비해 구글 비전은 태그(tag)의 우선순위(퍼센트 기준)를 데이터에 따라 공개하기 때문에 개발자 입장에서 50%가 넘지 않는 확률을 배제하는 등의 결정을 내릴 수 있습니다. 개인적으로는 이러한 부분으로 신뢰도가 올라가지 않았나 생각합니다.

* 딥러닝을 통해 이미지를 분석하는 아마존 웹 서비스 도구

텍스트 인식

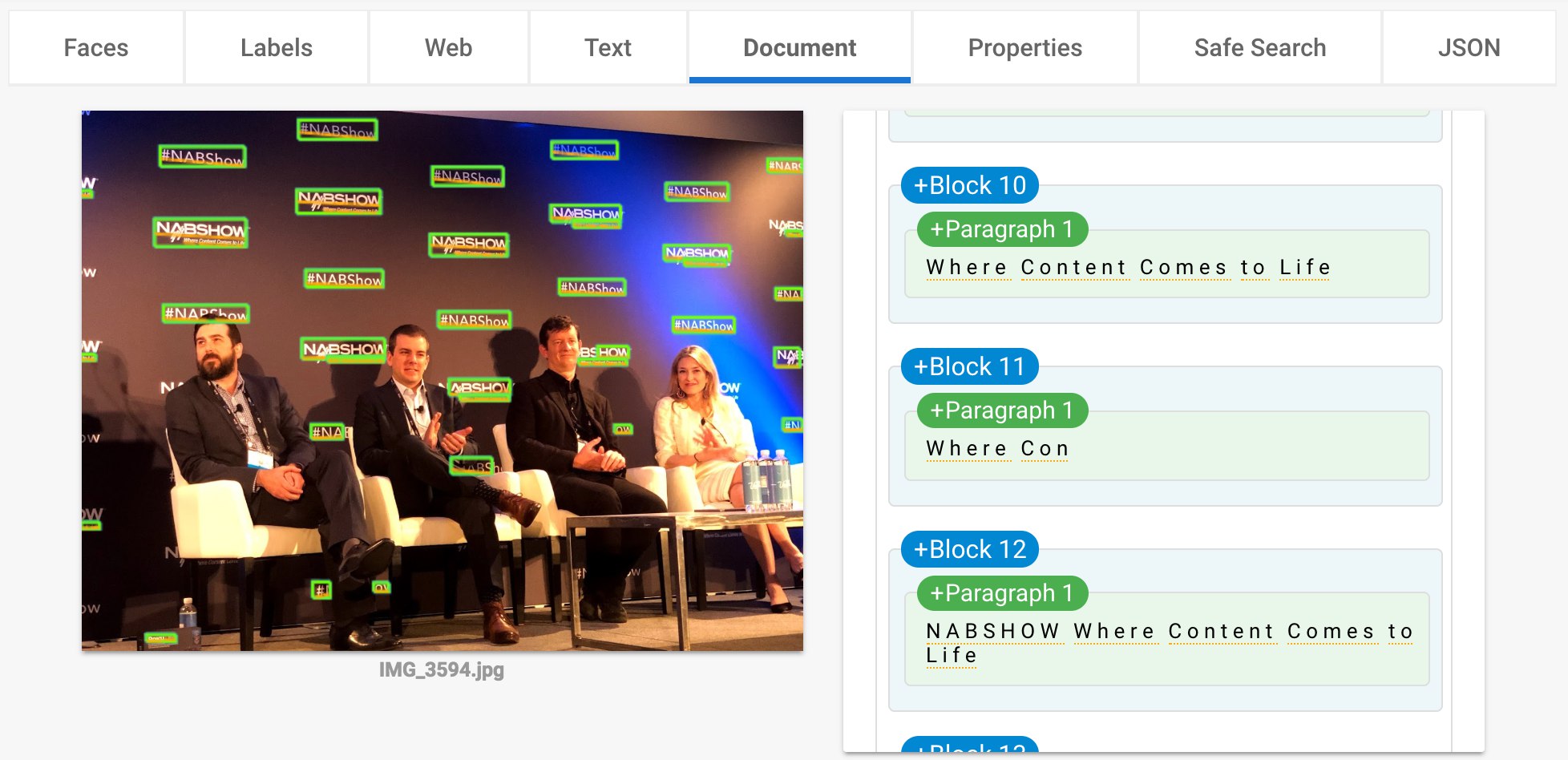

텍스트를 인식하는 Document탭 (사진 제공: 김조한)

구글 비전은 표정, 상황, 텍스트 모두 아마존 레코그니션보다 우위에 있다는 생각이 들었는데요. 그중 텍스트 인식률이 가장 뛰어났습니다. 사진 인식도 매우 훌륭했지만, 영어권이 아닌 한국에서 이 기능을 100% 사용할 수 있는지 가늠하기가 어려웠습니다.

이는 아마존 AI 기능들 역시 마찬가지입니다. 영어권에 특화된 서비스인 아마존 프라임 비디오도 아직 일부 자막만 한글을 지원할 뿐, 모든 서비스가 영어를 기본으로 구성되어 있습니다. 특히 X-Ray*는 영어만 지원합니다.

* 아마존 프라임 비디오의 핵심 기능. 자세한 설명은 저자의 브런치에서 확인할 수 있다.

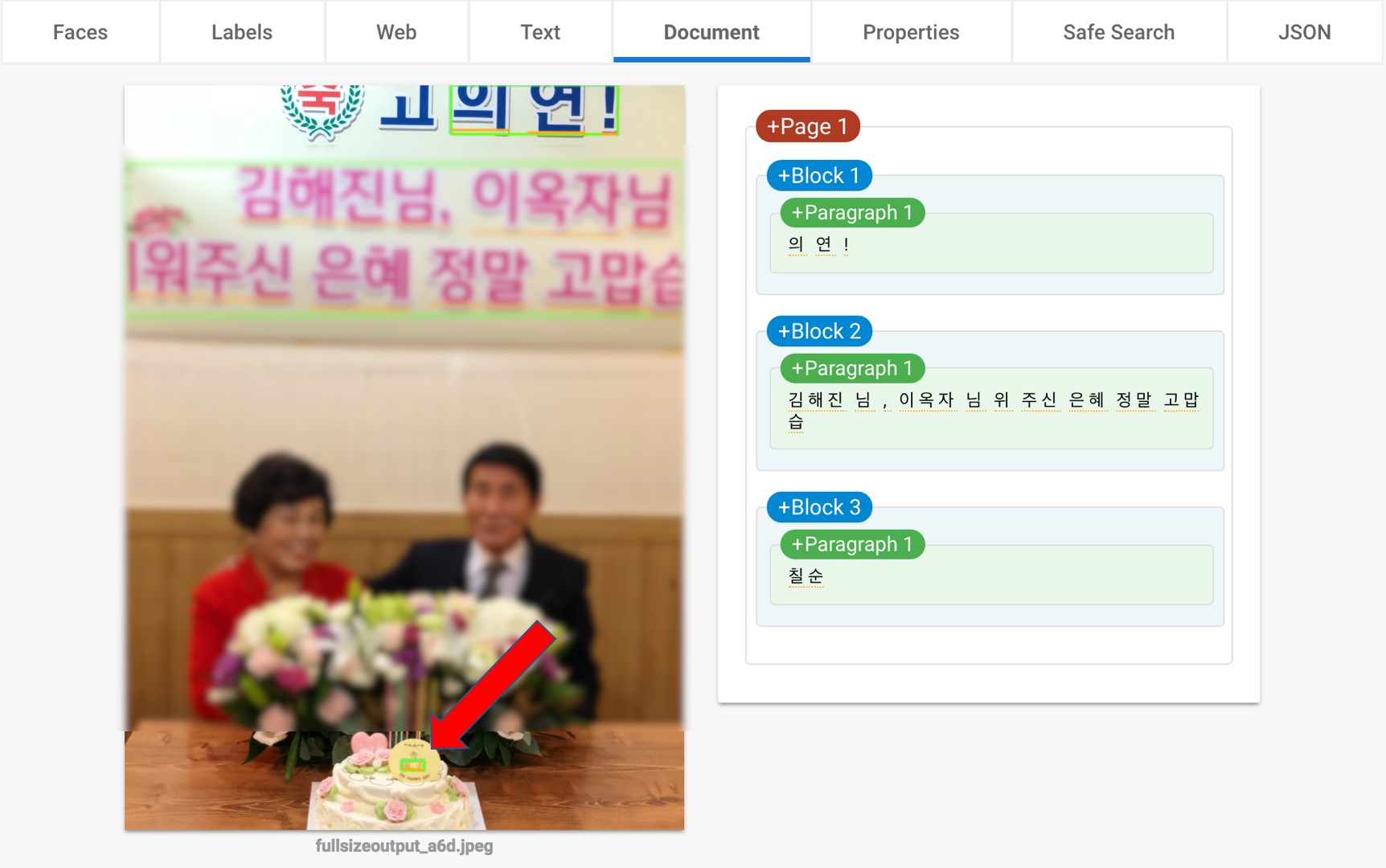

비전으로 본 부모님 칠순 잔치 사진 (사진 제공: 김조한)

부모님 칠순 잔치 때 썼던 사진에 한글 단어가 있기에 한번 돌려봤는데요. 인식이 너무나 잘 되었습니다. 특히 '칠순'이라는 단어를 어디서 인식한 걸까 궁금했는데, 따로 화살표 표시한 부분처럼 저 작은 이미지를 통해 칠순으로 인식했음을 확인할 수 있었습니다.

다시 '구글 vs 아마존' 구도로

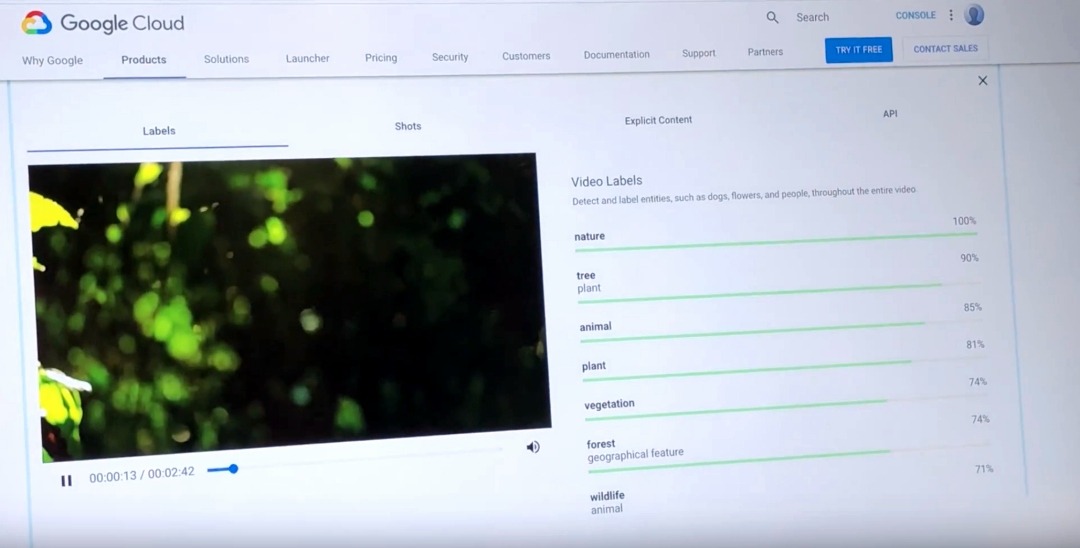

아마존의 레코그니션이 동영상에 좀 더 특화되어 있다면, 구글은 이미지에 집중하고 있습니다. 구글은 아마존이 자랑하는 타임코드 메타데이터(timecode metadata)*를 제공하지 않기 때문입니다. 구글은 영상을 인식할 때 몇 분 몇 초에 관련 데이터가 나왔다고 분류하고 기록해주는 형태가 아니라, 해당 영상에 이런 상황 정보(labels)들이 있었다고 요약해주고 있습니다. 왜일까요?

* 비디오 콘텐츠는 재생에 따라 시간 단위로 메타데이터(영화나 TV쇼를 나타내는 포스터, 스틸샷, 제작연도, 시놉시스, 캐스팅, 자막 등의 정보)가 존재하기에 해당 장면에 출연한 배우가 누군지도 알 수 있다. 아마존 X-Ray에서 구현 중인 기술로, 챕터 2에서 자세히 다룰 예정

유튜브 플랫폼에서는

아마존의 X-Ray처럼

타임코드 메타데이터가

필요하지 않기 때문입니다

유튜브의 메타데이터는 장면 검색이 아니라, 영상 하나를 검색하는 용도로 쓰이고 있습니다. 이 부분은 앞으로 개선되겠지만, 동영상을 두고 현재 수준을 가늠했을 때는 아마존이 확실히 우위에 있다고 말할 수 있겠습니다. 이미지만으로는 구글이 상당히 높은 수준에 올라와 있지만요.

하지만 구글이 해주는 상황 정보 분석은 콘텐츠의 영상 등급 결정 시, 심의가 필요한 콘텐츠(explicit content)*를 구별하는 데 활용하기 좋습니다. 북미에 특화된 아마존과 비교해 볼 때, 구글은 글로벌 관점에서 정보를 쉽게 확인할 수 있다는 특징을 갖고 있습니다. 구글 클라우드의 비디오 부문에서 중요한 포인트는 '글로벌'입니다.

* 욕설, 성적 표현, 특정 인종을 비하하는 단어 등의 매우 과격한 내용이 담긴 콘텐츠

앞선 사진에서 한글을 인식했던 OCR(optical character recognition)*도 아마존에게는 없는 부분입니다. 가장 중요한 사실은 지금 이 순간에도 계속 진화하고 있다는 것이죠. 리포트를 발행하고 나서도 많은 변화가 있을 것입니다.

* 이미지나 문서상에서 글자를 인식하는 기술

Google video intelligence. 아마존처럼 매 장면마다 데이터가 변경되지 않고, 생각보다 많은 데이터를 제공하지는 않았다. (사진 제공: 김조한)

그렇기 때문에 구글이 가진 유튜브라는 동영상 플랫폼과 비슷한 결과물을 만들고 싶은 사업자에게는 구글이 여전히 매력적인 것도 사실입니다. 그런 사업자들이 흥미를 보이는 부분이 자막 플랫폼으로서 유튜브가 지닌 매력입니다. (글로벌 자막 플랫폼으로서 유튜브가 가진 강점은 최종 리포트에 이어집니다.)

ㅡ

[넥스트 미디어, 테크와 AI를 만나다 - 미디어가이 in 2018 NAB Show]

미디어 기술이 발전함에 따라 어떤 미래가 펼쳐질지 궁금했던 미디어가이가 2018 NAB Show로 향했습니다. 미디어 업계의 신흥 강자와 전통 강호가 모인 이곳에서 넥스트 미디어의 가능성을 엿보고 한국 미디어 시장에서는 어떤 기회가 있을지 고민한 흔적을 나눕니다.